13 機械学習の進化:データから学習するコンピュータ

第12回では、AIの長い歴史を概観しました。その中で触れたように、現代のAI、特に生成AIの発展を支えているのが「機械学習」です。機械学習とは、人間がルールを明示的にプログラミングするのではなく、コンピュータがデータから自ら学習し、タスクを実行するためのモデルを構築する技術です。この章では、機械学習の進化の過程と、その主要な手法について解説します。

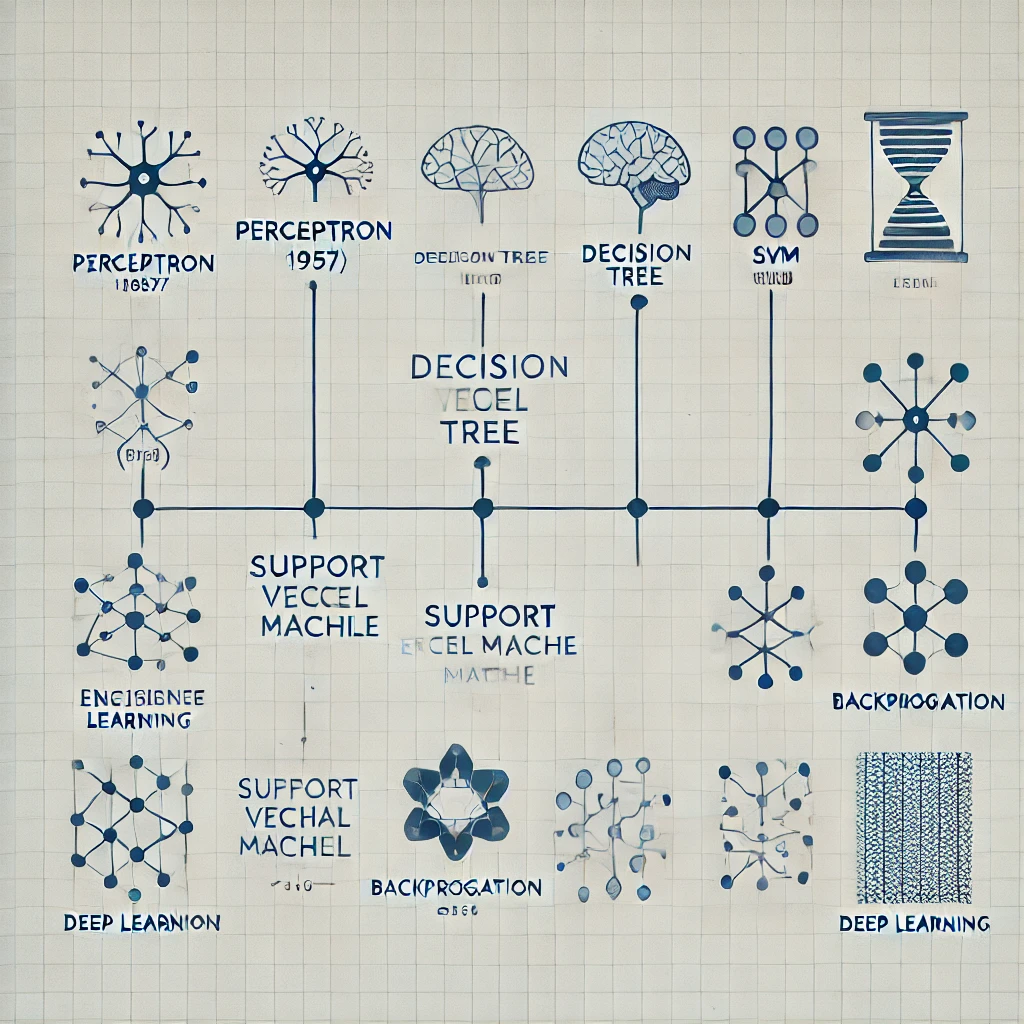

機械学習の黎明期:パーセプトロン

機械学習の初期のモデルとして、1957年にフランク・ローゼンブラットによって提案された「パーセプトロン」が挙げられます。

- 単純なニューラルネットワーク: パーセプトロンは、人間の脳の神経細胞(ニューロン)の働きを模した、単純な構造のニューラルネットワークでした。

- 線形分類: 入力データに対して、重み付けを行い、その合計値がある閾値を超えたかどうかで、出力を決定する(2クラスに分類する)ものでした。

- 限界: 単層パーセプトロンは、線形分離可能な問題しか解くことができず、XOR問題(排他的論理和)のような非線形問題を解くことができませんでした。

機械学習の発展:決定木、SVM、そしてアンサンブル学習

パーセプトロンの限界が明らかになった後、様々な機械学習の手法が開発されました。

- 決定木 (Decision Tree): 木構造を用いて、データを分類・回帰する手法です。条件分岐を繰り返すことで、データを段階的に分類していきます。

- 利点: 学習過程が理解しやすく、結果の解釈が容易です。

- 欠点: 過学習を起こしやすく、汎化性能が低い場合があります。

- サポートベクターマシン (SVM): データを高次元空間に写像し、最適な境界線(超平面)を見つけることで分類を行う手法です。

- 利点: 高い分類性能を持ち、汎化性能も高いとされています。

- 欠点: 学習に時間がかかり、大規模データへの適用が難しい場合があります。

- アンサンブル学習: 複数の学習モデルを組み合わせることで、予測精度を向上させる手法です。

- バギング: 異なる学習データで学習させた複数のモデルの予測結果を、平均や多数決で統合する(例:ランダムフォレスト)。

- ブースティング: 前のモデルの誤りを修正するように、逐次的にモデルを学習させていく(例:勾配ブースティング)。

これらの手法は、現代でも様々な分野で活用されています。

ニューラルネットワークの復活:バックプロパゲーション

1980年代後半、ニューラルネットワークの学習アルゴリズムである「バックプロパゲーション(誤差逆伝播法)」が再評価され、多層パーセプトロンの学習が可能になりました。

- 多層パーセプトロン: 入力層と出力層の間に、複数の中間層(隠れ層)を持つニューラルネットワークです。

- バックプロパゲーション: 出力層から入力層に向かって誤差を伝播させ、各層の重みを更新していく学習アルゴリズムです。

- 非線形問題への対応: 多層パーセプトロンは、XOR問題のような非線形問題も解くことができるようになりました。

ディープラーニングの登場:深層学習がもたらしたブレイクスルー

そして、2000年代後半以降、「ディープラーニング」が登場し、機械学習は大きな転換期を迎えます。

- 多層化: 中間層をさらに多層化することで、より複雑な特徴を学習できるようになりました。

- 特徴表現の自動学習: ディープラーニングでは、人間が特徴量を設計する必要がなく、ネットワークが自動的に特徴を学習します。

- 画像認識、自然言語処理などでの飛躍的進歩: ディープラーニングは、様々な分野で従来の手法を大幅に上回る性能を示しました。

ディープラーニングの登場により、機械学習は新たなステージへと進化したのです。

生成AIを支える機械学習

現代の生成AIは、このディープラーニングを基盤としています。

- 大量のデータから学習: 生成AIは、大量のテキスト、画像、音声などのデータから、その特徴やパターンを学習します。

- 確率的モデル: 生成AIは、学習したデータに基づいて、確率的に新しいデータを生成します。

機械学習は、生成AIの根幹を支える重要な技術なのです。

次回は、「ディープラーニングのブレイクスルー:画像認識と自然言語処理の飛躍」と題して、ディープラーニングがもたらした具体的な成果について解説します。